近年来,大模型领域呈现百花齐放的态势,自OpenAI推出GPT-3以来,国内外众多企业纷纷投身其中,掀起了一场“百模大战”。xAI、谷歌、微软、百度、科大讯飞、智源、阿里巴巴、字节跳动等企业竞相发布各自的大模型,同时,DeepSeek也作为一股新兴力量崭露头角。在一轮接一轮的AI浪潮下,大模型走向“技术摸高+工程创新”之路:一方面,企业更关注高效、稳定、开放的底座;另一方面,聚焦于便捷、易用、性价比的平台,致力于工程创新。

事实上,DeepSeek的一系列举措进一步印证了这一发展趋势。中关村在线认为,DeepSeek正凭借其卓越的性能表现、显著降低的算力成本以及积极的开源策略,加速推动大模型技术的广泛普及与快速迭代。与此同时,DeepSeek实现的技术突破,不仅驱动算力需求的变革,还实现了“算力堆砌”转向“算力优化”。特别是,DeepSeek在开源周里发布的大规模跨节点专家并行(大EP),更是揭开推理服务提高吞吐、降低时延的技术秘诀,掀起大模型推理系统优化的热潮。

何为大规模跨节点专家并行?

以DeepSeek为代表的大模型创新为算力基础设施也带来新的技术趋势:大模型向大量小专家方向演进,性能提升、成本降低开始快速普及;另一方面,少量大专家模式走向高性能摸高,大量小专家向创新普及,未来两种方案并存。同时,DeepSeek采用的大规模跨节点专家并行,实现性能、吞吐量和并发用户数量的显著提升,成本大幅度降低,也为大模型推理系统采用大规模跨节点专家并行方案提供了可行性。

在这些因素的驱使下,大模型推理系统开始采用大规模跨节点专家并行的方式,通过大规模的专家并行带来更大的吞吐,更低的延迟。何为大规模跨节点专家并行?其实是将专家Expert分布到更多的卡上,减少每张卡权重加载的时延,减少权重的显存占用,能够显著的提升单卡并行的路数,每个专家计算路数的提升可以提高矩阵乘的效率,从而实现更大的吞吐和更低的时延。

尽管大规模跨节点专家并行集群推理能够降低成本,但在实际应用中仍面临专家动态均衡与通信时延等挑战。优化负载均衡、缩减通信开销以及高效利用资源,是当前亟待解决的技术难题。针对这些难题,昇腾大EP推理通过多专家负载均衡和极致通信优化,实现极致吞吐,单卡性能提升到3倍,Decode时延降低50%+,实现更高性能,提升客户体验。

昇腾大EP推理方案有哪些关键技术?

MoE模型本身不同专家网络的激活次数存在显著差异。部分专家网络可能需要处理海量数据,而另一些则相对“轻松”,这导致部分NPU过载,部分NPU则处于闲置状态,影响推理效率。昇腾大EP推理方案,通过自动寻优、自动配比、自动预测、自动降解,实现备份节点和副本专家灵活可扩展、高可用和极致均衡。

PD分离部署创新是昇腾大EP推理方案又一关键技术。传统部署方案PD同节点部署,计算访存资源竞争,业界PD静态分离方案,提升系统资源利用率,但不够灵活,无法适应动态调整的场景。而华为创新autoPD分离部署方案,自动感知负载变化,无需人工介入,自动伸缩P、D实例,结合多级缓存内存资源池化,提升系统有效吞吐50%+。

同时,昇腾大EP推理方案通过双流/多维混合并行,平均性能提升30%,Prefill micro-batch双流并行,Prefill阶段,拆分Batch成两组更细粒度的Batch,实现计算和通信相互掩盖。MoE expert专家双流并行,共享专家和路由专家计算独立,利用Cube和Vector计算单元,实现两条Stream并行计算。Weight预取双流并行,利用L2 Cache大容量,通信和权重加载采用两条Stream并行,降低权重加载时间,提升matmul算子性能。

此外,昇腾MLAPO融合算子也是关键技术之一,降低计算耗时70%。我们知道,MLA预处理阶段,传统方案多算子串行,频繁占用内存、通信等资源,整体计算耗时占比高。而昇腾MLAPO融合算子,将小算子融合成单一算子,Vector和Cube计算并行处理,减少开销降低计算耗时。

国产算力需求大爆发,昇腾将如何发力?

中关村在线了解到,DeepSeek通过优化算法大幅降低了算力需求,然而,其高性价比特性极大地推动了AI的普及,从而促使算力需求呈现出了指数级的增长态势。对于国内的算力产业而言,DeepSeek的这一创新无疑为国产算力带来了新的发展机遇,即将开启一波蓬勃发展的浪潮。在此背景下,昇腾也秣马厉兵,蓄势待发。

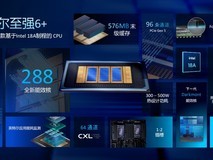

具体来看,昇腾打造一系列解决方案,不仅涵盖了大EP方案,还从预训练、微调、强化学习到推理集群、一体机,提供了全流程、全覆盖的解决方案。昇腾是业界首个能够复现DeepSeek R1强化学习流程的方案提供商。同时,在性能方面,华为凭借自有的硬件和软件,实现了与MoE架构的协同优化。MTP、MLA、大EP并行等技术,与昇腾技术架构高度契合,能够充分发掘底层资源潜力,释放卓越性能。

此外,昇腾在生态方面有着广泛的优势,其中,软件采用开源和开放策略,能够兼容业界主流框架。

昇思作为华为自主研发的深度学习框架,也提供了强大的支持。推理方面拥有自有的MindIE引擎,并支持vLLM等业界领先技术,让用户能够高效地进行自主训练和创新。更为重要的是,未来还将携手众多合作伙伴打造新的解决方案。

国产算力迎来新发展机遇的一个重要原因在于技术向更高效MoE模式的演进,这使得作为H100简化版的H20芯片,其现有硬件设计正面临被淘汰的风险。尤其在处理高batch size任务时,H20性能易达瓶颈,时延剧增,难以发挥DeepSeek专家并行机制的高吞吐优势,导致在大EP集群部署时系统吞吐率大幅下降,企业需承担高昂成本与性能低下的双重压力。因此,业界对国产算力的前景持越来越乐观的态度。

写在最后

在大模型持续涌现的时代,围绕算法、算力、数据,及相关技术设施、解决方案创新将驱动大模型向科技普惠的方向发展。特别是DeepSeek掀起的推理系统优化热潮,也将带动大模型推理方面的算力创新,而昇腾大规模跨节点专家并行集群推理也将驱动国产算力的蓬勃发展,中关村在线也相信。在大模型上下游企业的努力下,大模型技术正在推动AI在行业、企业及消费者领域的普及,实现AI普惠。

本文属于原创文章,如若转载,请注明来源:大模型推理系统优化浪潮下,昇腾大规模跨节点专家并行集群推理有哪些优势?https://server.zol.com.cn/960/9603315.html