在数字化浪潮的推动下,人工智能正成为重塑世界的关键力量,海量的推理、训练需求推动着底层硬件的新一轮更新与迭代。6月3日,在Computex 2024年的展会的主题演讲上,AMD正式公布了其代号为“Turin”的下一代的EPYC服务器处理器,旗舰产品拥有高达192个Zen 5核心和384个线程。AMD称其为“全球最好的数据中心处理器”。

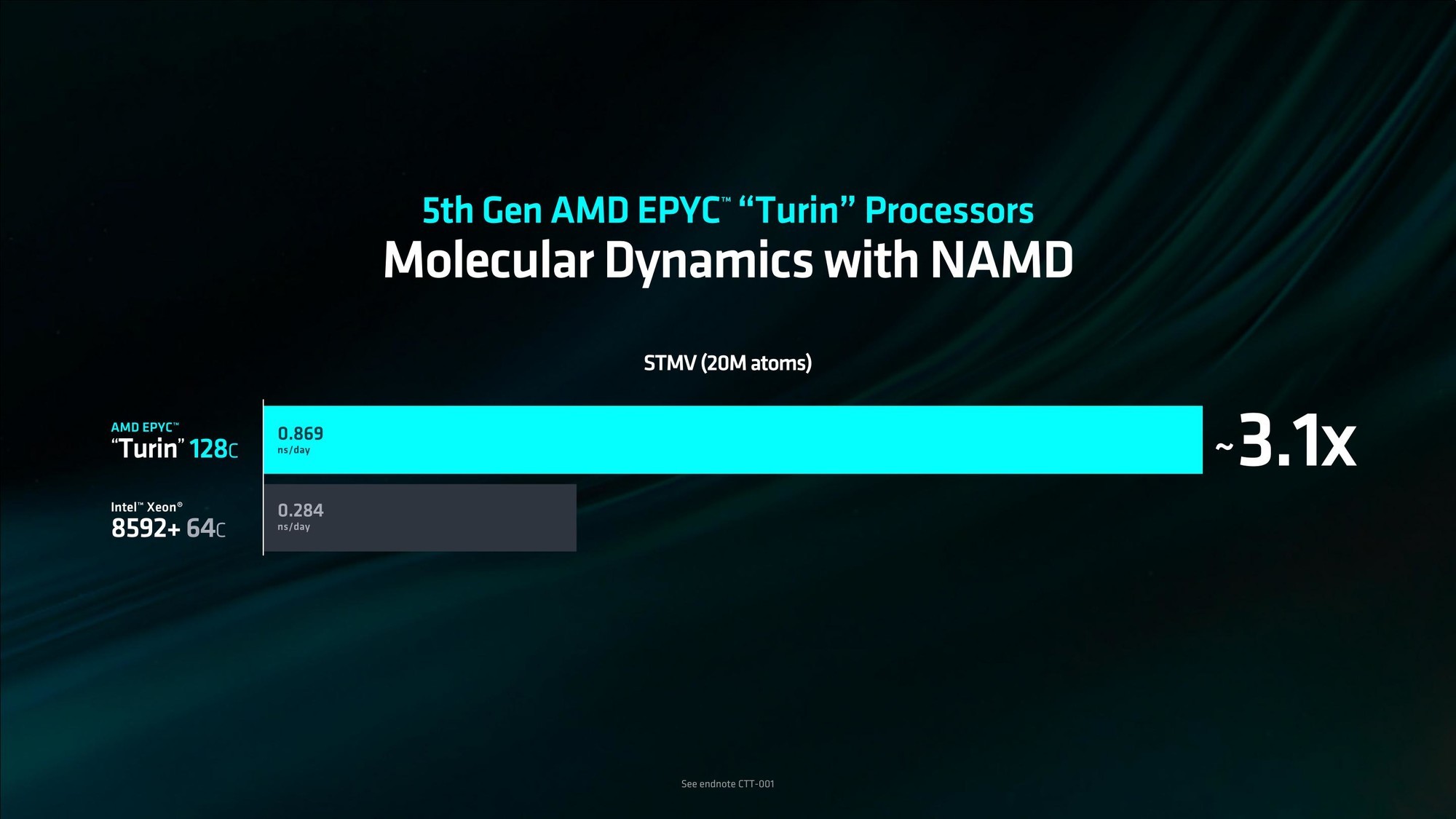

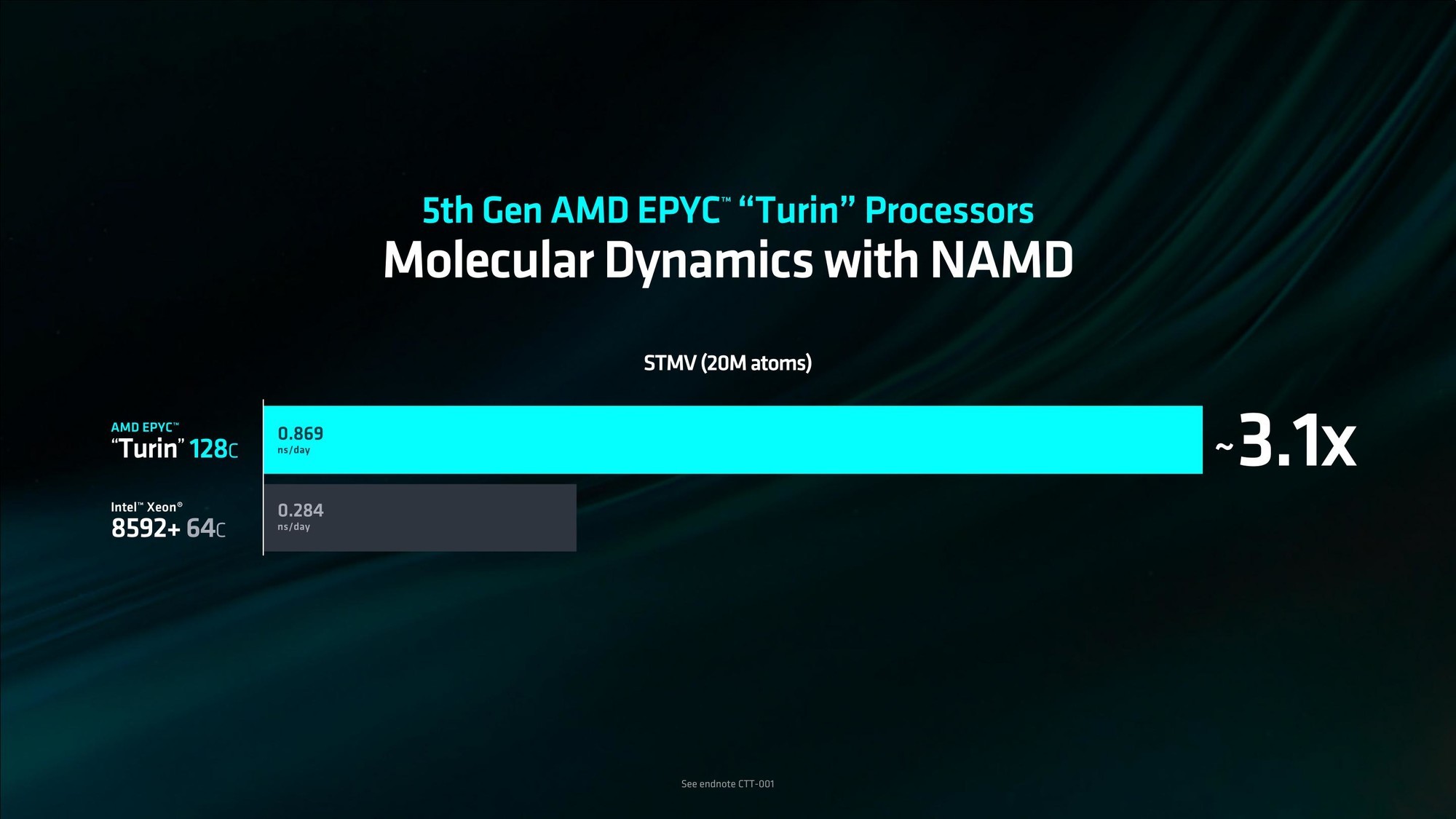

当然,新产品的推出自然少不了数据上的对比,根据AMD官方公布的数据显示,与现有的Zen4 EPYC处理器相比,新一代Turin在性能上实现了显著飞跃,提供了2.5倍至5.4倍的性能提升。其128核心的Turin的性能达到了英特尔64核心的Xeon 8592+的3.1倍。

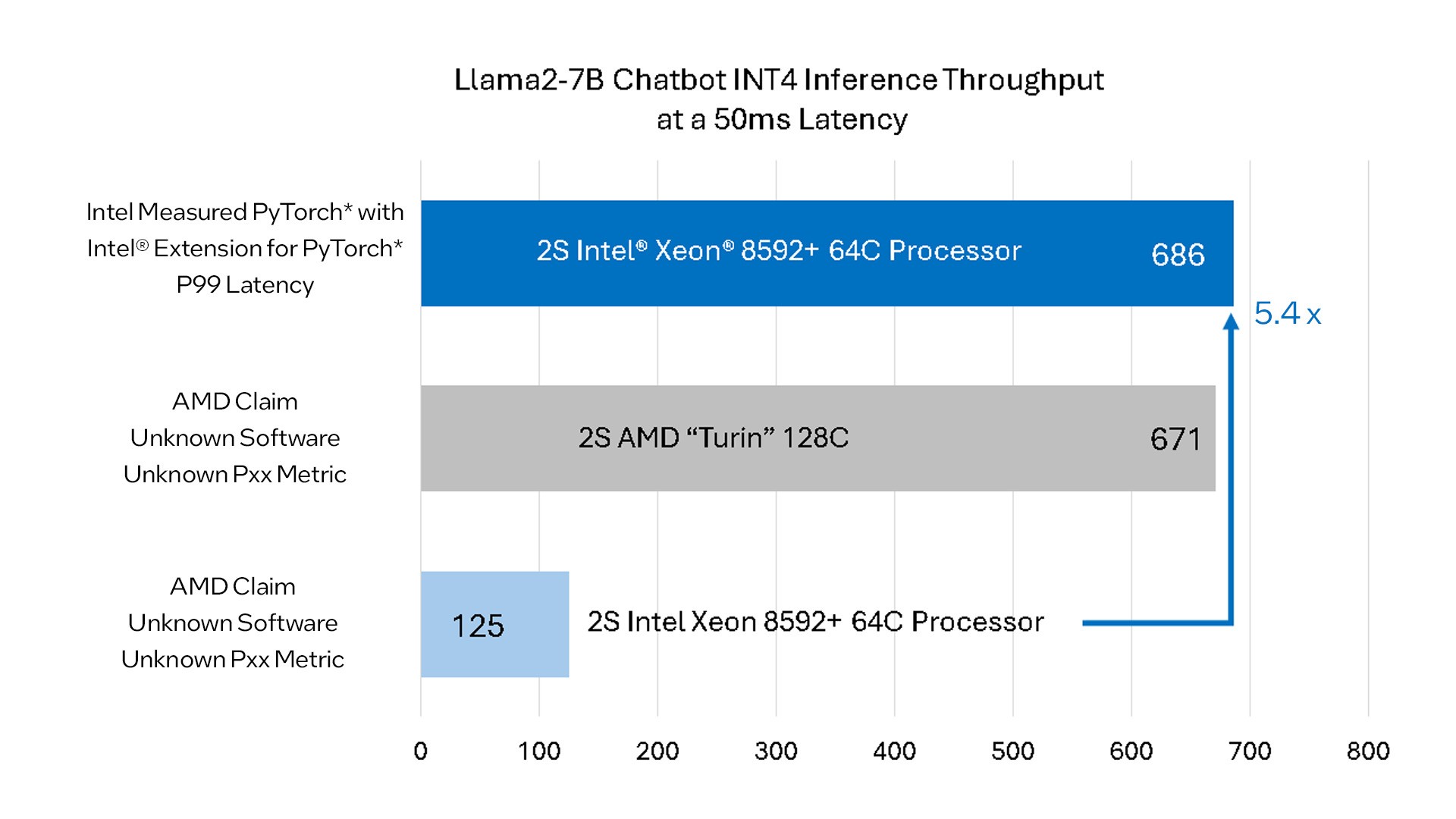

不过从英特尔发布的声明来看,AMD针对两款产品在基准测试上的对比实际上“有失偏颇”,如果使用经过优化的开源软件进行基准测试的话,第五代至强可扩展处理器的表现反而会优于AMD的下一代EPYC处理器。

这也符合英特尔多年来“软硬结合”的思路,即通过软件优化更好地释放硬件潜能。作为英特尔于去年年底推出的产品,第五代至强可扩展处理器可以通过更多的核心数(64核心)、更大的内存带宽(5600MT/s)、更大的三级缓存(320MB),以及软件生态方面的优化来满足众多的AI负载。

事实上,目前在 PyTorch、TensorFlow、DeepSpeed等开源框架上,英特尔都做出过重要贡献,英特尔不仅优化了这些平台,还将最新的技术创新投入到开源框架中,使更多企业和开发者受益。英特尔还举了一个对LLM推理进行不懈优化的例子:在2023年第三季度,与默认的PyTorch相比,LLM的延迟在10周内减少了5倍。这也从侧面印证了软硬件的协同的必要性。

英特尔表示,在Llama2-7B聊天机器人用例中,如果使用Intel Extension for PyTorch(P99延迟)对AMD的下一代Turin处理器和第五代至强可扩展处理器进行对比的话,第五代至强可扩展处理器的性能实际上比AMD展示的要高出5.4倍,达到了686 Tokens/s的输出,与此前AMD所展示的结果截然相反。

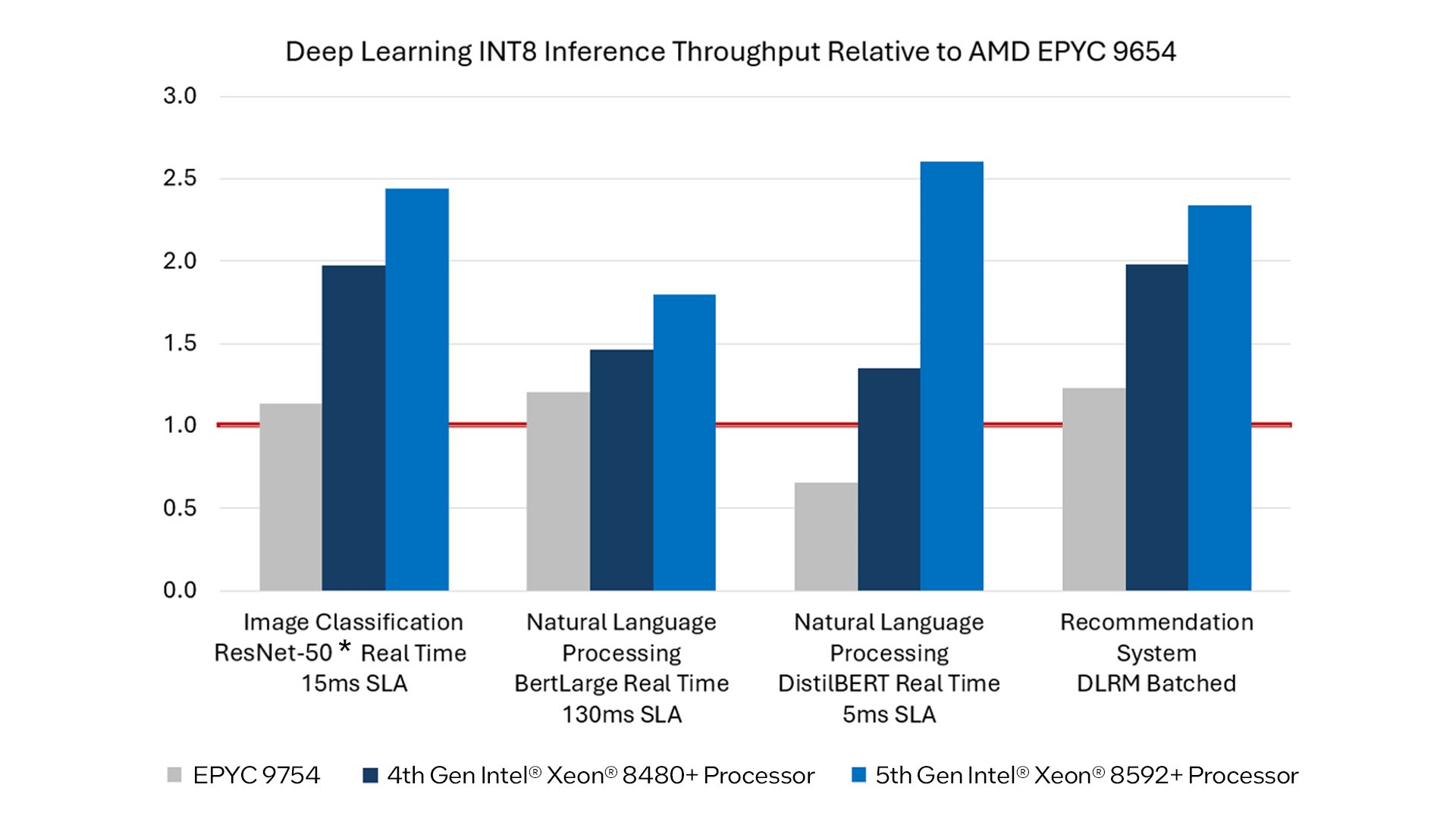

同时英特尔还强调,与AMD Genoa和Bergamo相比,第四代和第五代英特尔至强可扩展处理器在流行的数据类型int8的一系列深度学习推理用例中也都实现了领先。

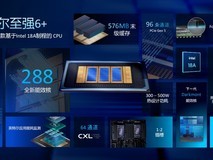

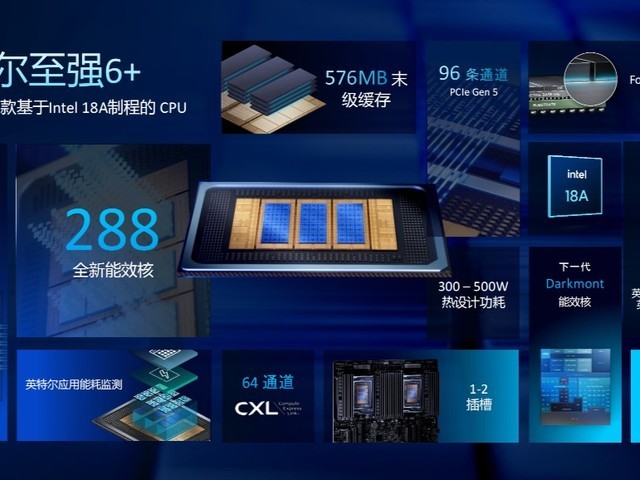

虽然目前至强6的性能核产品Granite Rapids还尚未发布,不过从英特尔的规划来看,至强6900系列将包含最多包含128个性能核以及288个能效核的产品,并且拥有与下一代AMD EPYC处理器相同的12通道DDR5内存接口,两家厂商在AI领域的争夺依然十分激烈。

本文属于原创文章,如若转载,请注明来源:英特尔:优化后的第五代至强可扩展处理器AI性能显著强于AMD EPYC Turinhttps://server.zol.com.cn/877/8776152.html