数据中心正在等待一场升级。

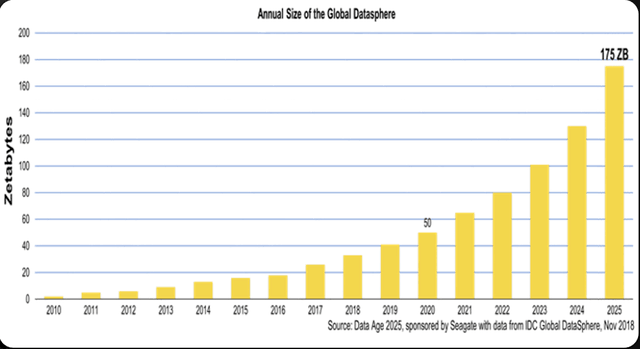

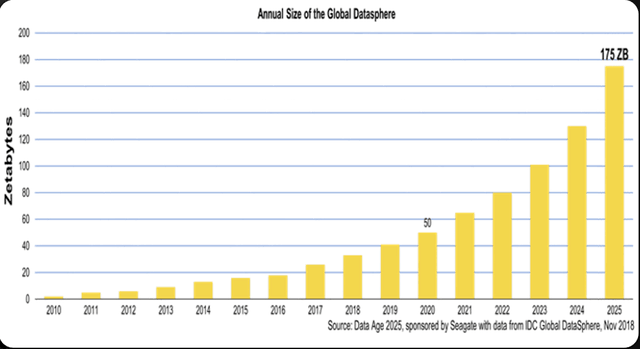

新基建正在以我们肉眼可见的速度稳步推进,不难想象的是,随着5G的发展和应用,数据中心将会迎来一次新的发展契机,但更多的则是来自各方面的挑战。大规模的连接和海量的数据会推动数据中心规模和设备密度的进一步加剧,而视频、直播等新兴应用的普及也会使得数据中心的负载越来越多样和复杂,硬件在提高密度的同时也必须具备更大的灵活性。从IDC最新的统计和预测可以看到,全球数据圈会在2018年的32ZB增长到2025年的175ZB,如此海量数据的增长自然需要更多的计算能力进行运算和处理。

全球数据圈将会大幅增长

海量数据当道,数据中心节能减耗迫在眉睫

除了更高的设备密度,数据中心要面临的另一个问题则来自于能耗方面。随着边缘计算、大数据、人工智能等新技术的发展,数据中心需要更高性能的服务器满足业务的发展需要。但根据摩尔定律的发展,芯片的升级也带来了芯片温度的提高,给服务器那颗滚烫的“芯”降温成为了亟待解决的问题。更低能耗的数据中心,不仅关系到了环境的可持续发展,也决定了算力的成本和服务的竞争力。

英特尔数据中心平台事业部首席工程师高级平台架构师龚海峰

在今年的OCPChinaDay峰会上,英特尔数据中心平台事业部首席工程师高级平台架构师龚海峰表示,边缘数据中心的发展速度十分之快,与大型数据中心不同的是,容量相对较小,只有十几个机柜,也并不采用顶级元器件的边缘数据中心,工作环境要更加恶劣,既要解决高密度的计算问题,又要解决能效的问题,简言之,数据中心需要具备更高的可靠性,更低的成本和功耗。

全国也在出台相应的政策,以上海为例,上海最近发布了新建数据中心PUE严格控制在1.3以下,可以预见的是,如果放任不管,无论是对环境的污染还是对能源的浪费都是很严重的,无论是国家还是各个地方政府,对未来的大规模数据中心的建设都会严格控制。

数据中心早期并没有专用的精密空调,也没有统一的标准,最早的时候用的甚至还是民用大功率空调,到上世纪70年代,机房专用精密空调出现,可以有效保障数据中心的恒温恒湿环境,而除尘方面采用新风系统和机房正压除尘,从而满足数据中心保持适度恒定,良好的空气洁净度、具备远程监控等要求。但在当下的市场环境里,风冷则面临着很多窘境,抛去能耗升高的问题不谈,风冷失效率上升的因素包含温度、振动、粉尘、潮湿等,而这些因素也会同时造成硬盘、主板、内存等元器件的故障,进而影响到整个数据中心的可靠性。

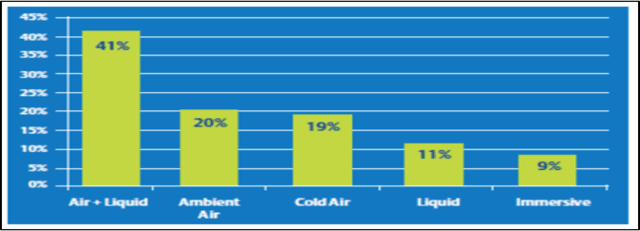

根据第三方数据公司统计,到2025年,常见的自然风冷技术会得到广泛使用,风冷+液冷混合的分散方案会成为主流,浸没式液冷的方案也会得到大量应用。

未来冷却技术使用比例预测

风冷未央,液冷已至,“老”技术仍待升级

从年龄上看,液冷技术也是十多岁的大龄技术了,但发展比较缓慢,究其原因还是落地、部署及运行的过程中存在不少问题,以浸没式液冷为例,之前鲜有互联网数据中心大规模进行部署,首先是液冷的可靠性,如果可靠性不能达到和风冷一个级别,那使用液冷就变得毫无意义。再就是由于介质的改变,元器件是否能在液体中可以长期稳定的工作,液体的导电性如何,很多诸如此类的问题,最后就是运维的挑战,密度变高之后,重量也会增加,维护也会更难。

阿里云基础设施服务器研发架构师钟杨帆

“阿里云从2015年开始对比了不同的冷却架构,包括空气冷却,冷板液冷,我们从不同的维度进行总结和对比。从空气冷却到冷板液冷,从各个方面进行对比,我们实践中不同的尝试着验证迭代,我们总结出一些对比可以看到,浸没液冷是数据中心的一个跃迁式的技术创新,具有高可靠、高可用的特点。”阿里云基础设施服务器研发架构师钟杨帆说道。

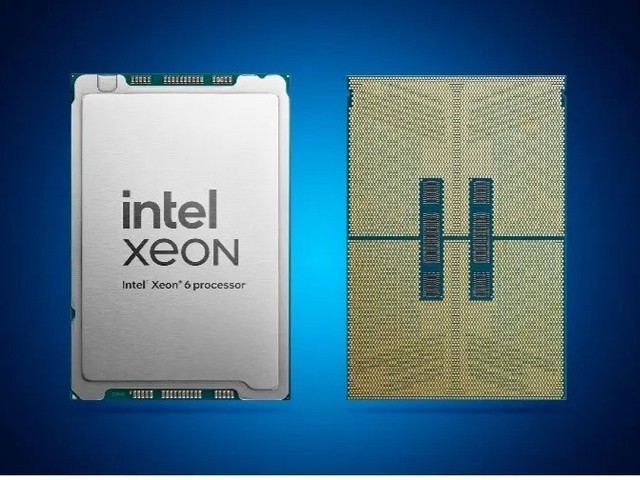

要实现绿色数据中心,首先要解决的是电子元器件产品方面的问题,英特尔对CPU的路线图,其产品策略就是在制造风冷产品的同时,也大力发展支持液冷的产品,同时英特尔对四种液冷方式都在做产品开发,以适应未来液冷普及的需求。而阿里巴巴则从2016年开始尝试大规模部署液冷技术,今年在杭州建成了全球规模最大的浸没液冷数据中心,这也是全中国首个绿色数据中心。相比传统的数据中心,阿里云这一个数据中心每年可以节省至少上千万的电。

阿里巴巴绿色数据中心实践

相比传统的风冷,浸没式液冷几乎不依赖任何气象条件,可以在高温、高湿、甚至在腐蚀性极强的环境中进行,此外噪音也比较小,对于运维人员来讲也是十分大的改善。但到了具体的使用场景,首先要考虑产品对业务性能的要求,再根据业务性能要求选择元器件,再根据业务的算力选择CPU或者元器件的型号后,根据对应的TDP选择液冷或者风冷。除此之外,机房的基础设施、机柜的功率密度、可靠性的要求、PUE的要求,机房占地面积等要求都对采取的冷却方式有所影响。

机房冷却技术的发展将在很大程度上推动着数据中心的发展,随着计算存储网络以及各种应用的加速,这种设备的虚拟性能的要求对散热提出了更高的挑战,如何帮助数据中心达到节能绿色环保的要求,对液冷这个面世虽早,但仍然具有很大发展潜力的技术而言,也需要更多的实践探索。

本文属于原创文章,如若转载,请注明来源:节能只“靠天吃饭”?绿色开放数据中心时代悄然开启//server.zol.com.cn/757/7577226.html