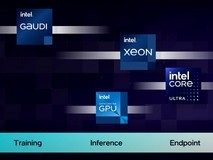

在Meta发布Llama 3大语言模型的第一时间,英特尔即优化并验证了80亿和700亿参数的Llama 3模型能够在英特尔AI产品组合上运行。在客户端领域,英特尔锐炫显卡的强大性能让开发者能够轻松在本地运行Llama 3模型,为生成式AI工作负载提供加速。

在Llama3模型的初步测试中,英特尔酷睿Ultra H系列处理器展现出了高于普通人阅读速度的输出生成性能,而这一结果主要得益于其内置的英特尔锐炫GPU,该GPU具有8个Xe核心,以及DP4a AI加速器和高达120GB/s的系统内存带宽。

英特尔酷睿Ultra处理器和英特尔锐炫显卡在Llama 3模型发布的第一时间便提供了良好适配,这彰显了英特尔和Meta携手为本地AI开发和数百万设备的部署所做出的努力。英特尔客户端硬件性能的大幅提升得益于用于本地研发的PyTorch和英特尔PyTorch扩展包等丰富的软件框架与工具,以及用于模型部署和推理的OpenVINO工具包。

在内置英特尔锐炫显卡的英特尔酷睿Ultra7上运行Meta-Lama3-8B-Instruct

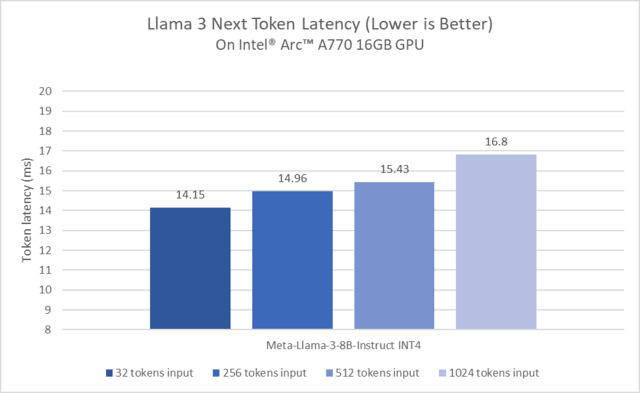

在英特尔锐炫A770上运行Llama3的下一个Token延迟

上图展示了在搭配PyTorch框架和针对英特尔GPU的优化后,英特尔锐炫A770显卡在运行Llama3模型时表现出卓越的性能。除此之外,英特尔锐炫显卡亦支持开发者在本地运行包括Mistral-7B-InstructLLM、Phi2、Llama2等在内的大语言模型。

基于相同的基础安装,开发者可以在本地运行多种模型的主要原因,可以归功于IPEX-LLM,即一个针对PyTorch的大语言模型库。它主要基于英特尔PyTorch扩展包打造,涵盖时下最新的大语言模型优化和低比特数据压缩(INT4/FP4/INT8/FP8),以及针对英特尔硬件的大多数最新性能优化。得益于如锐炫A系列显卡等英特尔独立显卡上的Xe核心XMX AI加速功能,IPEX-LLM能够显著提高性能,其支持在Windows子系统Linux版本、原生Windows环境和原生Linux上的英特尔锐炫A系列显卡。

由于所有的操作和模型均基于原生PyTorch框架,开发者可以非常方便地更换或使用不同的PyTorch模型以及输入数据。而上述模型和数据不仅能够在英特尔锐炫显卡上运行,开发者亦能享受到英特尔锐炫显卡加速带来的性能提升。

本文属于原创文章,如若转载,请注明来源:第一时间适配!英特尔锐炫GPU在运行Llama 3时展现卓越性能https://server.zol.com.cn/867/8676225.html