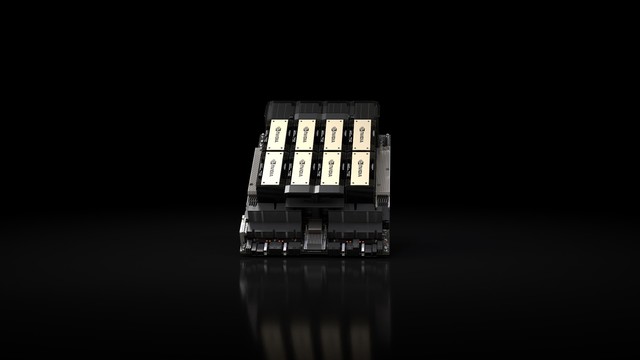

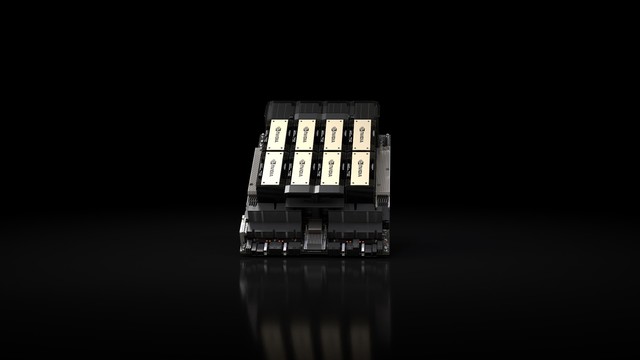

北京时间11月13日消息,NVIDIA宣布推出NVIDIA HGX H200,为Hopper这一全球领先的AI计算平台再添新动力。NVIDIA HGX H200平台基于NVIDIA Hopper架构,搭载NVIDIA H200 Tensor Core GPU和领先的显存配置,可处理生成式AI与高性能计算工作负载的海量数据。

NVIDIA为全球领先的AI计算平台Hopper再添新动力

NVIDIA H200是首款采用HBM3e的GPU,其运行更快、更大的显存容量将进一步加速生成式AI与大语言模型,同时推进用于HPC工作负载的科学计算。凭借HBM3e,NVIDIA H200能够提供传输速度达4.8 TB/秒的 141GB显存。与上一代架构的NVIDIA A100 相比,其容量几乎翻了一倍,带宽也增加了2.4倍。

全球领先的服务器制造商和云服务提供商预计于 2024 年第二季度开始提供搭载H200 的系统。

NVIDIA超大规模和高性能计算副总裁Ian Buck表示:“想要通过生成式AI和HPC应用创造智能,就必须使用大型、快速的GPU显存来高速、高效地处理海量数据。借助NVIDIA H200,业界领先的端到端AI超级计算平台的速度将会变得更快,一些世界上最重要的挑战,都可以被解决。”

持续的创新带来持续的性能飞跃

与前代架构相比,NVIDIA Hopper架构实现了前所未有的性能跃升,而H100持续的软件升级,包括最近发布的 NVIDIA TensorRT-LLM等强大的开源库,都在不断提升其性能标准。

H200的推出将带来进一步的性能飞跃,比如在一个700亿参数的LLM ——Llama 2上的推理速度比H100提高了近一倍。随着未来软件的持续升级,H200有望实现更大的性能优势与提升。

NVIDIA H200的规格

NVIDIA H200将提供四路和八路NVIDIA HGX H200服务器主板可选,其与HGX H100系统的硬件和软件都兼容。同时还可用于今年 8 月发布的采用HBM3e的NVIDIA GH200 Grace Hopper超级芯片。这些配置使H200可以部署在各类数据中心,包括本地、云、混合云和边缘。

在NVIDIA NVLink 和NVSwitch高速互连技术的加持下,HGX H200可为各种应用工作负载提供最高的性能,包括针对1750亿参数以上超大模型的LLM训练和推理。

八路HGX H200可提供超过32 PetaFLOPS的FP8深度学习计算能力和1.1TB的聚合高带宽内存容量,能够为生成式AI和HPC应用带来强劲性能。

当H200与采用超高速NVLink-C2C互连技术的NVIDIA Grace CPU搭配使用时,就组成了带有HBM3e的GH200 Grace Hopper超级芯片——专为大型HPC和AI应用而设计的计算模块。

使用NVIDIA全栈式软件加速AI

NVIDIA加速计算平台具备强大软件工具支持,能够助力开发者和企业构建并加速从AI到HPC的生产就绪型应用,包括适用于语音、推荐系统和超大规模推理等工作负载的NVIDIA AI Enterprise软件套件。

供应情况

NVIDIA H200将于2024年第二季度开始通过全球系统制造商和云服务提供商提供。

本文属于原创文章,如若转载,请注明来源:NVIDIA为全球领先的AI计算平台Hopper再添新动力https://server.zol.com.cn/841/8419936.html