随着各大公司争相加入人工智能的潮流,芯片和人才供不应求。初创公司SambaNova声称,其新处理器可以帮助公司在几天内建立并运行自己的大型语言模型(LLM)。

SAMBANOVA

这家总部位于帕洛阿尔托的公司已经筹集了超过10亿美元的风险投资,不会直接向公司出售芯片。相反,它出售其定制技术堆栈的访问权限,该堆栈具有专门为运行最大的人工智能模型而设计的专有硬件和软件。

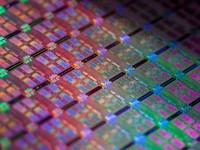

在该公司推出新的SN40L处理器后,该技术堆栈现在得到了重大升级。每个器件采用台湾芯片巨头台湾半导体制造有限公司的5纳米工艺制造,具有1020亿个晶体管,分布在1040个核上,速度高达638万亿次。它还有一个新颖的三层内存系统,旨在应对与人工智能工作负载相关的巨大数据流。

“A trillionparameters is actually not a big model if you can run it on eight [chips].”

—Rodrigo Liang, SambaNova

SambaNova声称,一个仅由八个芯片组成的节点能够支持多达5万亿个参数的模型,这几乎是OpenAI GPT-4 LLM报告大小的三倍。序列长度(衡量模型可以处理的输入长度)高达256000个令牌。首席执行官Rodrigo Liang表示,使用行业标准GPU也需要数百个芯片,这意味着总拥有成本不到行业标准方法的1/25。

Liang说:“如果你能在八个芯片插座上运行一万亿个参数,那么它实际上并不是一个大模型。我们正在瓦解成本结构,并真正重构人们对此的看法,而不是将万亿参数模型视为无法访问的东西。”

新芯片使用了与该公司以前的处理器相同的数据流架构。SambaNova的基本论点是,现有的芯片设计过于关注简化指令流,但对于大多数机器学习应用程序来说,数据的高效移动是一个更大的瓶颈。

为了解决这一问题,该公司的芯片采用了一个由高速交换结构连接的存储器和计算单元组成的平铺阵列,这使得根据手头的问题动态重新配置单元的连接方式成为可能。这与该公司的SambaFlow软件协同工作,该软件可以分析机器学习模型,并找出连接单元的最佳方式,以确保无缝数据流和最大限度地使用硬件。

除了从7纳米工艺转变为5纳米工艺外,该公司最新芯片与其前身SN30的主要区别在于增加了第三层存储层。早期的芯片具有640兆字节的片上SRAM和1兆字节的外部DRAM,但SN40L将具有520兆字节的芯片上存储器、1.5兆字节的内部存储器和额外的64兆字节的高带宽存储器(HBM)。

内存越来越成为人工智能芯片的一个关键区别,因为生成的人工智能模型不断膨胀,这意味着移动数据对性能的拖累往往大于原始计算能力。这促使公司提高芯片上的内存量和速度。SambaNova并不是第一个求助于HBM来对抗这种所谓的内存墙的公司,其新芯片的内存比竞争对手少——英伟达业界领先的H100 GPU的内存为80GB,而AMD即将推出的MI300X GPU的内存将为192GB。SambaNova不愿透露其内存的带宽数据,因此很难判断它与其他芯片的对比情况。

Liang说,虽然SambaNova更依赖于较慢的外部内存,但它的技术是一种软件编译器,可以智能地在三个内存层之间分配负载。该公司芯片之间的专有互连还允许编译器将八个处理器的设置视为单个系统。Liang表示:“训练中的表现将会非常棒。”

SambaNova对如何处理人工智能芯片的另一个热门话题——稀疏性也持谨慎态度。LLM中的许多权重都设置为零,因此对它们执行操作是浪费计算。找到利用这种稀疏性的方法可以提供显著的加速。SambaNova在其宣传材料中声称,SN40L“提供密集和稀疏计算”。Liang说,这在一定程度上是通过调度和如何将数据带到芯片上在软件层实现的,但他也拒绝讨论硬件组件。“稀疏问题是一个战场,”他说,“所以我们还没有准备好透露我们是如何做到的。”

帮助人工智能芯片更快、更便宜地运行大型模型的另一个常见技巧是降低参数的表示精度。SN40L使用谷歌工程师发明的bfloat16数字格式,也支持8位精度,但Liang表示,低精度计算不是他们的重点,因为他们的架构已经允许他们在更小的占地面积上运行模型。

Liang表示,该公司的技术堆栈明确专注于运行最大的人工智能模型——他们的目标受众是世界上2000家最大的公司。销售宣传是,这些公司坐拥大量数据,但他们不知道其中大部分都在说什么。SambaNova表示,它可以提供构建人工智能模型所需的所有硬件和软件,解锁这些数据,而无需公司为芯片或人工智能人才而战。Liang说:“你可以在几天内启动并运行,而不是几个月或几个季度。现在每家公司都可以拥有自己的GPT模型。”

Gartner分析师Chirag Dekate表示,SN40L可能比竞争对手硬件具有显著优势的一个领域是多模式人工智能。他表示,生成型人工智能的未来是可以处理各种不同类型数据的大型模型,如图像、视频和文本,但这会导致高度可变的工作负载。Dekate说,GPU中相当严格的体系结构不太适合这种工作,但这正是SambaNova对可重构性的关注所在。“你可以调整硬件以满足工作负载的要求,”他说。

然而,Dekate说,像SambaNova制造的定制人工智能芯片确实在性能和灵活性之间进行了权衡。尽管GPU可能没有那么强大,但它们几乎可以开箱即用地运行任何神经网络,并得到强大的软件生态系统的支持。Dekate指出,SambaNova一直在建立一个客户可以利用的预烘焙模型目录,但英伟达在人工智能开发各个方面的主导地位是一个重大挑战。

Dekate说:“这种架构实际上优于传统的GPU架构。但除非你把这些技术掌握在客户手中,实现大规模消费化,否则我认为你很可能会陷入困境。”

咨询公司SemiAnalysis的首席分析师Dylan Patel表示,由于英伟达也在通过其DGX云产品进军全栈人工智能即服务市场,这将更加具有挑战性。“芯片是向前迈出的重要一步,”他说。

本文属于原创文章,如若转载,请注明来源:IEEE: SambaNova的新芯片可运行比OpenAI的ChatGPT高级版大两倍以上的模型https://server.zol.com.cn/835/8359992.html